“Ver para crer” Este ditado popular deriva de uma ideia simples: algo só se torna real ou verdadeiro quando nossos olhos podem atestar isso. Assim, durante décadas, um vídeo era suficiente para provar que um evento havia ocorrido.

Esse ditado, no entanto, foi ‘por água abaixo’. Na era da inteligência artificial (IA), um vídeo pode mostrar o que nunca aconteceu. E embora muitos acreditem que poderiam detectar a fraude, a verdade é que as tecnologias, técnicas e truques se tornaram tão sofisticados que conseguem enganar até mesmo os olhos mais treinados.

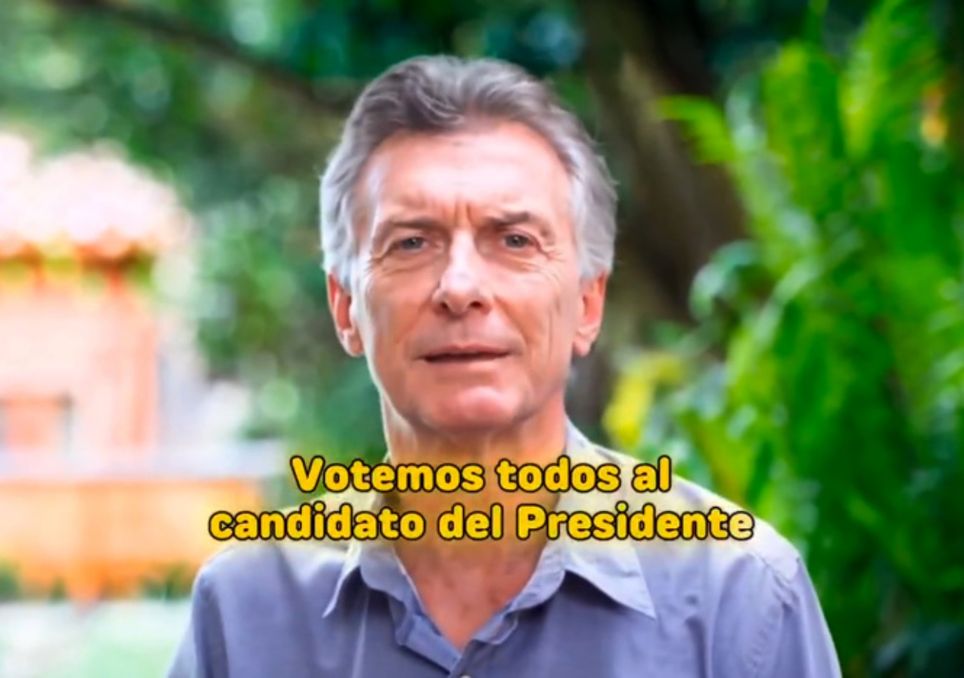

O que é perturbador é que a IA não apenas altera imagens: ela também molda nossa confiança no que vemos, com implicações que vão do cotidiano à formação de opinião pública e de preferências políticas.

Os chamados deepfakes e os vídeos gerados por IA estão desafiando nossas noções de evidência, de confiança e, em última análise, da verdade. Como podemos saber se o que vemos é falso? Ainda existem algumas pistas, embora talvez não por muito tempo.

Três pistas: resolução, qualidade e duração

Pode parecer contraintuitivo, mas um dos principais sinais de um vídeo falso é justamente a sua baixa qualidade. “É uma das primeiras coisas que analisamos”, disse à BBC Hany Farid, professor de ciência da computação na Universidade da Califórnia, em Berkeley, pioneiro em perícia digital e fundador da empresa GetReal Security.

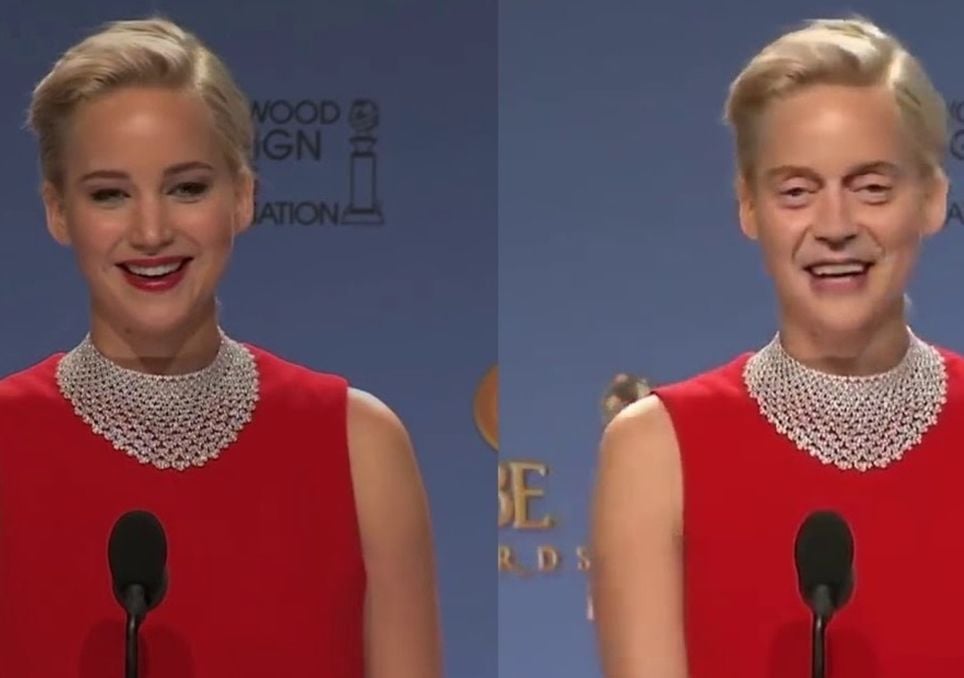

Imagens granuladas, bordas borradas, cores desbotadas: essa aparência pode ser uma escolha deliberada. Vídeos borrados escondem pequenas inconsistências com as quais a IA ainda tem dificuldades, como oscilações estranhas, texturas de pele excessivamente lisas, reflexos impossíveis ou cabelos que mudam de forma.

Farid explicou que os criadores de vídeos falsos diminuem intencionalmente a resolução. “Se eu quero enganar as pessoas, eu crio meu vídeo falso, depois reduzo a resolução e adiciono compressão para disfarçar quaisquer falhas potenciais”, disse ele à BBC. É uma técnica simples e eficaz.

Vídeos falsos costumam ser mais curtos — entre 6 e 10 segundos — porque criar vídeos mais longos exige mais recursos e aumenta o risco de erros visíveis. Além disso, os criadores tendem a comprimir os arquivos para esconder as falhas digitais que poderiam denunciá-los.

Um exemplo viral deixou isso claro: o vídeo dos coelhinhos pulando em uma cama elástica, visto mais de 240 milhões de vezes no TikTok. Parecia uma gravação fofa de uma câmera de segurança noturna, mas era completamente falso.

O mesmo aconteceu com o casal se apaixonando no metrô e o pregador americano fazendo um sermão anticapitalista. Todos compartilhavam aquele aspecto pixelado, quase amador, que os fazia parecer verossímeis.

Um futuro sem pistas visíveis

O problema é que esses sinais estão desaparecendo. “Tenho más notícias”, disse Matthew Stamm, professor da Universidade Drexel e diretor do Laboratório de Multimídia e Segurança da Informação, à BBC. “Prevejo que essas pistas visuais desaparecerão dos vídeos em dois anos. Não será mais possível confiar no que se vê“.

Os modelos mais avançados, como o Sora (da OpenAI) ou o Veo (Google), já produzem vídeos quase perfeitos. Diante disso, os pesquisadores estão recorrendo a métodos forenses mais sofisticados: eles rastreiam “impressões digitais estatísticas” invisíveis nos pixels, imperceptíveis ao olho humano. “Modificar um vídeo deixa rastros, como impressões digitais em uma cena de crime“, explicou Stamm.

Ao mesmo tempo, grandes empresas de tecnologia estão trabalhando em sistemas para garantir a autenticidade: câmeras que registram a origem do arquivo ou marcas d’água digitais que permitem saber se o conteúdo foi criado por IA.

Designação de origem: o valor de quem publica

Quando você não pode mais confiar nos seus olhos, confiar nas fontes se torna essencial. O especialista em alfabetização digital Mike Caulfield afirmou isso claramente em entrevista à BBC: “O vídeo se tornará algo como o texto: a procedência, e não as características superficiais, será fundamental”.

Saber quem publica um vídeo pode ser a melhor defesa contra manipulação atualmente. Um vídeo anônimo nas redes sociais não é o mesmo que uma gravação divulgada por um veículo de comunicação respeitável e rastreável. Nesse cenário, a credibilidade passa do conteúdo para o remetente ou a fonte.

A tecnologia, entre a filosofia e a política da verdade

O problema dos vídeos falsos é, em última análise, uma questão filosófica e política. Se a simples observação já não basta para discernir a verdade, a própria noção de verdade — fundamento do jornalismo, da justiça e da democracia — entra em crise.

“Acredito que este seja o maior desafio de cibersegurança do século 21”, afirmou Stamm. Para solucioná-lo, serão necessárias tecnologia, alfabetização digital e pensamento crítico.

Entretanto, em meio a algoritmos, deepfakes e pós-verdade, o apelo à vigilância torna-se cada vez mais importante e urgente. A dúvida, como método, nunca foi tão necessária. E o pensamento crítico parece ser, hoje, a única garantia de não perder completamente o contato com a realidade.